はじめに

クリスマスはいつものように全く予定無かったあんちべです、こんばんは!

皆様はクリスマスをお楽しみになられましたでしょうか?

「今yesと答えた奴ら全員地獄に堕ちろ」ってサンタさんにお願いしておいたからな。

さて、世間のリア充様がクリスマスで浮かれまくりやがっていらっしゃる中、

やること無さ過ぎていつものようにpixivで腐女子向け作品を眺めていたところ、

ありがたいことに寂しさを感じる暇もない勢いでどんどん作品が投稿されていました。

ハッピーですね!

…………?

クリスマスの真っ只中に腐女子絵を投稿している…だと!?

クリスマスと言えば皆さんお楽しみのはずでは?

いや、クリスマスの夜にむしろ投稿数が増加しているような気が…?

という疑惑を抱いたので、実際データを色々眺めてみましょう。

データの説明

データはpixivから下記タイトルで検索した結果を12/26の午前中時点で

各々1万件弱(タイトルによって多少件数異なります)取得したものです。

今回分析するのは次の10タイトルです。

そっちの方面でも大変人気なタイトルですね。

- Free!

- TIGER&BUNNY

- うたの☆プリンスさまっ♪

- テニスの王子様

- ハイキュー

- ヘタリア

- 銀魂

- 黒子のバスケ

- 弱虫ペダル

- 戦国BASARA

pixivでは主だった指標として

閲覧数、評価回数、総合点の3つを取得することが可能です。

閲覧数はその絵を見た回数*1、

評価回数は閲覧者がその絵に対して10点満点で点数を付けた回数*2、

総合点は各閲覧者の評価点の合計です。

その他、各作品に付与したタグ情報も取得出来ます。

なお、pixivからの具体的なデータ取得方法は以前書いた進撃の巨人のアレをご参照ください。

時系列分析

期間は12/1~12/25、各タイトルの投稿数を日次で並べたもの。

セルの色が赤ければ赤い程そのタイトル内で

その日の投稿数は多いということを表している。

まずは黙ってこの結果を見てくれたまえ。

クリスマスイブ・クリスマス当日、半分以上のタイトルが真っ赤ですよ!

何やってんだ皆さん*5!!!

折角のクリスマスを作品投稿に費やしていいのですか*6???

特にタイバニ、クリスマス当日なんて

平均値の2倍以上というか3倍近い投稿枚数ですよ!!!

それはそれとして、今回は皆さんにも頑張って分析して頂きたいと思います。

上のようなツールを用意しました*7。

横軸が日付、縦軸が投稿枚数の折れ線グラフです。

使い方

- 右側のタイトル名をクリックすると線を消したり出したりできます

- グラフをマウスでドラッグするとその期間をズームアップ出来ます

- ズームアップ後、"Reset zoom"ってボタンが表示されるので押すとズームリセットします

以上。

ごちゃっとして見辛いと思いますので、適宜操作して良い感じにしてください。

データは11/1~12/25まで表示する設定になっています。

注意点として、上限1万件弱でデータ取ってきているため、黒子のバスケとヘタリアは

あまりにも投稿数多すぎて遡り取得が出来ず、

11月頭付近では一部データ欠損しています。

欠損している時点は-1という数値を埋めています。

これをグリグリやってなんかしてください。

実際実務でもこういうのを用いて時系列で相関してるっぽいタイトル群を見つけたり、

見る期間を変えながら他タイトルと比較したりしています。

これで何か面白い振る舞い見つけたらぜひ教えて下さい!

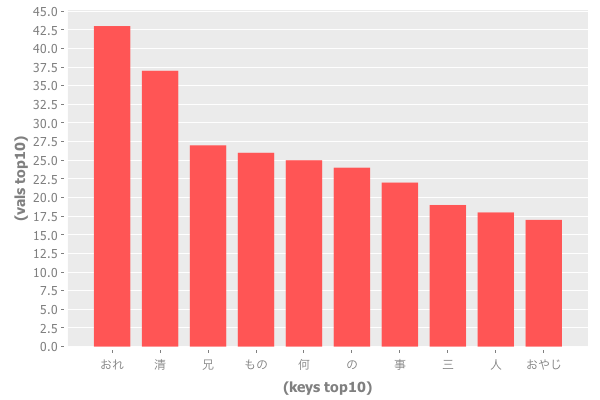

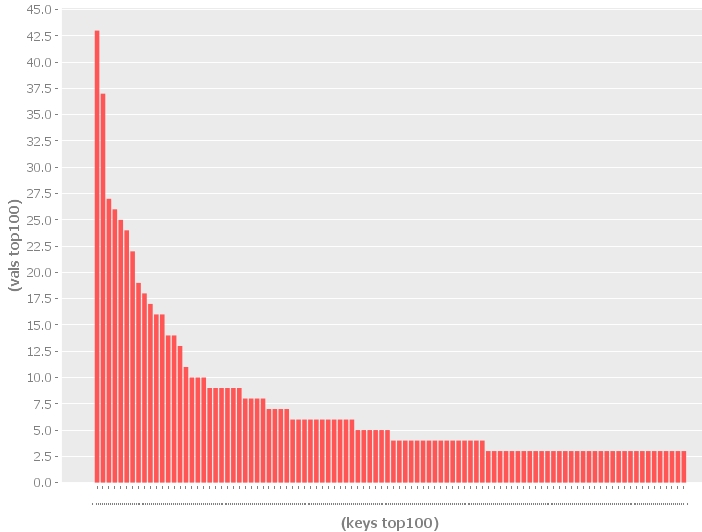

単語頻度

登場したタグの頻度をカウントしてみましょう。

こういう作品のタグを頻度毎にカウントすると人気キャラやカップリング、

あるいは作品を特徴づけるようなキーワードが拾えます。

具体的な手順ややり方、スクリプトは再度進撃の巨人のアレをご参照ください。

さて集計結果は…

どの作品にも「腐向け」タグが入っています。

しかも弱虫ペダルとハイキューに至っては

並み居るキャラを押しのけて1位が「腐向け」。

同じく、どの作品にも入っているタグがもう一つ…そう、「R-18」です。

特にタイバニなんてアレですよ、

1位が兎虎なのは鉄板カップリングだからまだ見て見ぬふりをするとして

2位が「腐向け」で3位が「R-18」ですよ、完全に特定目的ですよ。

っていうかやっぱりキャラ名じゃなくてカップリングが

最上位なのは見て見ぬふりできないよ!

どうなってるんだよタイバニ勢!

嘘だと言ってよ、バーニィ!

まぁ最後のが言いたかっただけなので次に進みましょう。

探索的データ解析って何?

進撃の巨人を読んだことない人がデータだけでキャラを推測してみる - あんちべ!

では「キャラを推測する」という明確なタスクを設けましたが、

今回はデータを様々な切り口で眺めまわすことによって

「どんなことがわかるかな?」とデータドリブンで分析を進めていきます。

基本的に、分析をする前に何らかの目的や仮説を設定しなくてはなりません。

無意味にデータを並べ立てても何も得るものはありません。

皆さんも単に数値やグラフが羅列されているだけの資料を見て

「で、何がわかったの?何が言いたかったの?」

となった経験は無いでしょうか?

しかし、分析者に分析対象となる分野の前提知識が無い場合や

そもそも分析対象内の変化が激しい場合、

また、その分野が一般には知られていない場合など、

適切な目的や仮説を設定すること自体が困難なケースもあります。

そのようなケースでは、「適切な目的や仮説を獲得する」という目的で

データを様々な切り口で眺めて探索するのも一つの手です。

このようなアプローチを統計学の世界の言葉で「探索的データ解析」と呼びます。

まぁようするに状況よくわかんねー時はひたすらデータを色々舐め回すことによって

なんか面白そうなこと見つけるべという話ですよ!!

ついでに、「データを様々な切り口で検証しまくること」を

統計学の世界の言葉で「データの尋問」と呼んだりします。

分析する際、「さーて、今からデータを尋問するかー」

と声に出して言えばテンション上がって

「最高にハイッってヤツだ!!」

状態になれるので是非口にしましょう!

ラブリーデータ!!!

データさえあれば恋人や友達はいなくとも人生は楽しい!!!

さぁpixivで(特に腐女子からの)人気の高い作品に

探索的データ解析を試みて楽しみましょう!!!

データを尋問してみる

データの尋問の最初の一歩はデータの特徴や性質を把握することです。

そのためには様々なデータを集計したり可視化したりします。

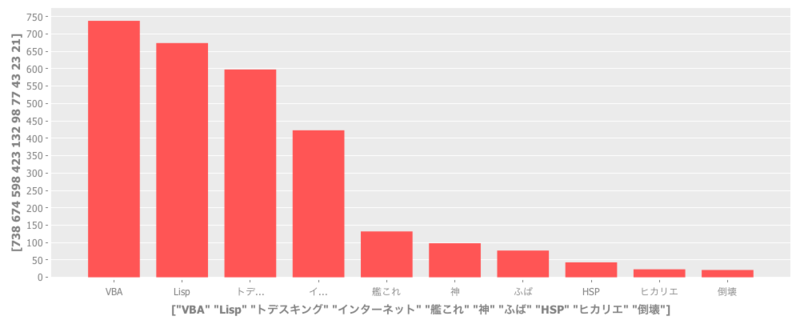

まず12/1~12/25の期間で各タイトルのUU(ユニークユーザ、延べ投稿者数)と投稿枚数を集計してみます。

*8

*8

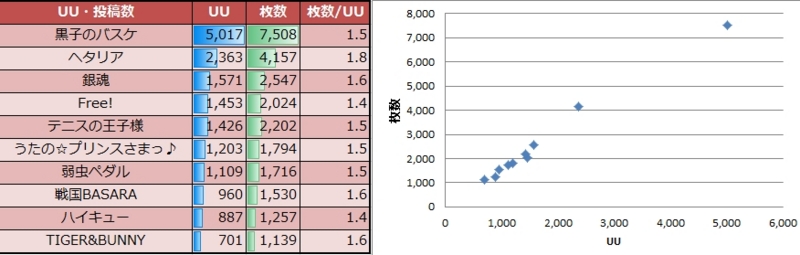

次にタイトルごとの投稿数トップ3ユーザの投稿枚数と、

期間内に10枚以上投稿したユーザ数を見てみましょう。

*9

*9

*10

*10

黒子のバスケ、圧倒的なUUと投稿枚数ですね。

また、テニスの王子様の投稿数トップ3の投稿枚数の多さと

ヘタリアの10枚以上投稿者数の多さ。

一か月弱という短い期間でこれほどの人数がこれほどの枚数投稿してるとは驚きです。

一日一枚以上投稿している計算になる方が何人かいらっしゃいます。

(深い愛を感じますね…。)

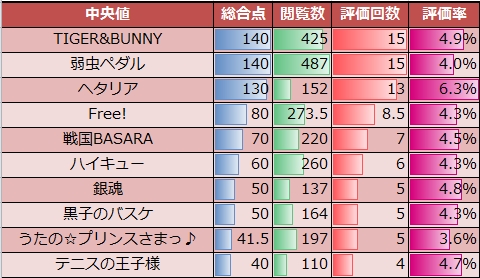

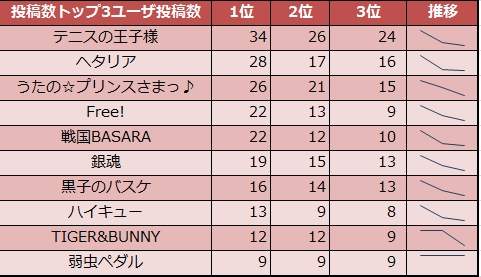

今度は総合点・閲覧数・評価回数各々の中央値と

評価率(総評価回数を総閲覧数で割った値)を見てみましょう。

中央値とはデータをソート(昇順でも降順でも良い)し、

その中央に位置する値の事です。

中央値は平均値と異なり飛び抜けて大きい値や小さい値に

左右されないという性質を持っています。

この性質を頑健性といい、探索的データ解析を行う段階では

データの分布形状が不明だったり極端な値が存在するケースも多々あるため、

この性質を重視します。

今回実際データを見てみたところ、

時々飛び抜けて大きい値が存在していたため中央値を利用します。

TIGER&BUNNY、弱虫ペダル、ヘタリアが非常に総合得点高いという結果です。

また、ヘタリアは他と比べて評価率が高いようです。

と言いますか、これだけの人気タイトルでも

評価率5%を切っているのが大半なんですね。

閲覧者の皆さんはこの評価率についていかがお考えでしょうか。

さて、今度は各指標の標準偏差を見てみます。

標準偏差は「どれくらいばらつきがあるか」を示す値で、

これが大きければ大きい程ばらつきが大きい、つまりピンキリであることを示します。

黒子のバスケが総合点、評価回数とも最もばらつきが大きく、

閲覧数も2位につけています。

UU・投稿枚数も多いのでばらつきが大きいのも妥当な話です。

逆にヘタリアがUU・投稿枚数では2位につけているにもかかわらず、

標準偏差で見ると総合点と評価回数で6位、閲覧数では7位というのも、

先程の総合点の中央値や評価率が高いことを組み合わせると中々面白いです。

これまでご覧頂いた中央値や標準偏差は

「要約統計量」というデータ全体を単一の値に要約するものです。

データ全体を見るのではなく値を一つ見るだけで済むため楽ですし、

比較する際大変便利ですが、様々な情報を削ぎ落としてしまいます。

ではデータ全体を見ればいいかというと、

10タイトル各々1万件弱、約10万件のデータがあるため、

人間が記憶・把握できる量の限界を遥かに超えています。

人間が把握できる範囲でもっとデータを詳細に見るため、

データを適切な範囲で区切り、

その範囲内に収まるデータがどの程度の個数あるかを見ることで

データの分布状況を確認します。

可視化する場合はヒストグラムや箱ひげ図を使うと良いでしょう。

今回は全作品をまとめた総得点の分布を元に、

グラフが山形になるような範囲*12で下記のように区切った

総得点のヒストグラムを見てみましょう。

*13*14

*13*14

これを見ると中々面白いことが色々わかります。

戦国BASARAは総合点0のレンジの比率が他よりかなり小さいようです。

TIGER&BUNNY、弱虫ペダル、Free!は1000点以上の作品が10%以上あります。

Free!は中央値的には上位に入りませんでしたが、

このようにヒストグラムで見ると結構高得点作品もあることが分かりますね。

黒子のバスケの1万点オーバー作品が1%なのは相当凄まじいですね。

100枚に1枚は1万点オーバー…。

さて、これらの集計結果から色々なことが判明しました。

判明したことを捨て置いては意味がありません、活用しましょう。

ここでは「どのタイトルを推薦するか」について考えてみます。

様々なアプローチがありますが、ここではペルソナ法と呼ばれる

「何らかのペルソナ(ある分野/層における典型的なユーザ)を想定し、

そのペルソナごとに分析結果を活用するシナリオを策定」

というアプローチをやってみましょう。

まず閲覧者というペルソナを用意します。

閲覧者のペルソナの最大欲求が「高評価な作品を見たい」

であると想定したとしましょう。

その場合、

- 1万オーバーの作品が特に多い黒子のバスケ

- 3000オーバーの作品が全体の5%以上を占めるFree!、TIGER&BUNNY

を薦めるなどが考えられます。

また、今度は投稿者のペルソナで考えてみましょう。

投稿者のペルソナの最大欲求が「高評価を得やすいタイトル」

であると想定したとしましょう。

- 閲覧数の多い弱虫ペダル

- 評価率が高いヘタリア

を薦めることが考えられます*15。

終わりに

統計分析 is 楽しい!

仮説検証系アプローチも良いけど、

特にデータ尋問して新しい何かを見出す探索的データ解析はとびきり楽しい!

昨今、市場変化が激しかったりそもそも新規開拓な市場だったりして、

仮説検証の前に仮説生成をしないといけないというケースもよくあります。

そういう場合は探索的データ解析の出番ですね。

市場の多様化に伴い、今後ますます未知の分野を

切り開いていく機会が皆さんにも訪れることでしょう。

私は腐女子受けする作品を殆ど知らないため、

まさに探索的アプローチを取るしかないという状況でした。

自分の良く知ってる分野と全然知らない分野両方を分析してみると

同じアプローチでは全然通用しないという事が分かります。

意識して自分の知らない分野を分析してみるの、大変面白いですよ。

精度の良い分類やレコメンド、複雑な検定を行うのも素晴らしいことですが、

探索的データ解析のような探索的アプローチを用いて

新市場を切り開いていく事例がもっと増えると良いなーと思います。

未踏を舐ろう!!

最近データを公開して下さる様々な企業や機関の尽力のお陰で、

割と簡単に色んなデータが取得出来るようになってきました。

例えば下記のAPIリンク集辿ると

皆さんの興味を引くデータが取得できるかもしれません。

http://www.find-job.net/startup/api-2013

楽しそうなのでやってみちゃいましょう!!

ではでは長文読んでいただきお疲れ様でした。

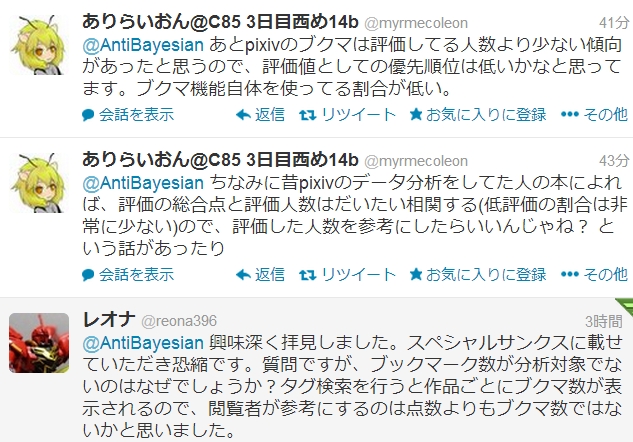

追記

ふむふむ、なるほど。

次回はブクマ数も考慮して分析しないとですね!

評価人数と総合点は仰る通り強い相関があり、

散布図描くとほぼ一直線にならぶのですが、

閲覧数と評価数はで散布図描くと近似曲線から大きく外れます。

つまり、評価率が作品によって異なります。特にヘタリアが顕著ですね。

なので評価人数だけではなく、評価率も見ようかという感じです。

ブクマ機能ですが、実際私自身使ってないので指標としてどう振る舞うかは

ちょっと分析してみないとわからないというのが本音です。

ただ、「100users入り」などブクマ数を考慮したタグを頻繁に見かけます。

pixivでは総合点の順に作品をソートする機能は有料であるため、

「***user入り」タグを辿ることによって高評価作品を探す、

という使い方をしていることも考えられるのではないでしょうか。

もし「ブクマ機能はこういう感じで使うんだよ」というの

ご存知の方いらっしゃったらお教え願いたいです。

ちなみに、pixivのプレミアム会員は月額525円で

素敵な機能が使えるようになります。

こういう素晴らしいサービスが赤字続きになって

存続出来なくなると大変悲しいので、

余裕のある方は是非プレミアム会員になって

いろんな機能を使いまくりましょう!*16

http://www.pixiv.net/premium.php

追記の追記

あんちべさんの記事の折れ線グラフツールで、黒バスの12月20日分が飛び抜けてるけど、これは作品の人気キャラのお誕生日だったことが原因だと思う。 参考→ 赤司征十郎生誕祭がすごい・・・!本日12月20日は赤司様の誕生日!おめでとー!! http://t.co/97wehnYrw8

— レオナ (@reona396) 2013, 12月 29テニスの王子様の12月4日分も投稿が増えているけど、この日も仁王雅治の誕生日だったみたい。次の5日の投稿もやや多いけど、この日は日吉若の誕生日

— レオナ (@reona396) 2013, 12月 29"クリスマスイブ・クリスマス当日、半分くらいのタイトルが真っ赤(投稿数が多い)"という結果が出てたけど、これはクリスマス記念作品を投稿している人が多いのかなーと思った

— レオナ (@reona396) 2013, 12月 29@AntiBayesian 次回があるんですね!期待しています。 タグによるブクマ数の表示はこちらが詳しいです: users入り (ゆーざーずいり)とは【ピクシブ百科事典】 http://t.co/wOSRRtpiv8

— レオナ (@reona396) 2013, 12月 29ご解説ありがとうございます!!!

参考文献

あまあまくろにくる 【2013年冬】コミケカタログカップリング調査10作品まとめ

http://tarte41.hatenablog.com/entry/20131215/1387305779

BL専門用語の基礎知識『腐女子用語辞典』

http://zatugakaarika.blog.fc2.com/blog-entry-2829.html

スペシャルサンクス

- pixiv

- @hathiko8

- @suruli

- @reona396

*1:1ユーザ1日1回だけカウントされます。F5アタックしても数増えません

*2:ある絵に評価与えられるのは1ユーザ1日1回だけです

*3:進撃の巨人は腐女子的にも人気タイトルでしたが、以前やったので今回は無しということで…

*4:なお、取得する際にダーティーなものは分析対象外にしています。例えば16列目に総合点が入っている筈なのですが、時々明らかに点数以外の物(何らかのタグや文字列など)が入っていたりします。

*5:自分の事は棚に上げつつ

*6:自分の事は棚に上げつつ

*7:表示されない場合はお手数ですがブラウザ更新お願いします

*8:※UU降順ソート

*9:※一位の投稿枚数降順ソート

*10:※人数降順ソート

*11:※総合点降順ソート

*12:他には等分になるよう区切る方法もあります

*13:※総合点が0点のものは未評価のため0点になっているものを含みます。

*14:※図上が比率表示、図下が個数表示です。 比率表示する場合、 1.データサイズが小さすぎて僅かな件数差が大きく反映される 2.各データのデータサイズが大きく異なる などのケースが存在するため、個数表示も添えて下さい

*15:ぶっちゃけここで挙げた推薦はあくまでも例えのための例えで、 実際は好みのタイトルは殆どの場合事前に決まっており 特に投稿者の場合推薦に従って投稿するなんてまず無いとは思います。 「AとBどっちを描こうかな?」と迷っている時であれば多少効果あるかもしれませんが

*16:というステマをしておいたのでpixiv様、毎回ネタにさせて頂いておりますが許して下さいませm(_ _)m